AI의 지능을 정량화하기 위한 시도는 오랜 세월 이어져 왔지만, 그 기준은 여전히 모호하다. 인간 지능조차 시험 하나로 평가하기 어려운 것처럼, 생성형 AI 모델의 성능 역시 단순한 수치나 테스트 점수로는 온전히 설명할 수 없다. 학문적 다지문 시험 방식의 기존 벤치마크들은 AI 모델 간 비교에 유용하지만, 현실의 복잡도와는 거리가 있다는 지적이 계속 제기돼 왔다.

대표적인 예가 MMLU(광범위 학문 기반 객관식 테스트)로, 이는 오랫동안 AI 모델의 성능을 측정하는 주요 수단으로 사용돼 왔다. 그러나 GPT-4.5와 클로드 3.5 소넷이 유사한 점수를 기록함에도 불구하고 실제 사용성에서는 확연한 차이를 보인다는 점에서, 단일 점수가 진짜 지능을 측정하는 데는 한계가 있다는 비판이 나온다.

이 같은 논의는 최근 ARC-AGI와 GAIA라는 새로운 기준의 등장으로 다시 불붙었다. ARC-AGI는 일반적 추론과 창의적 문제 해결력을 끌어낸다는 목적에서 개발됐고, GAIA는 보다 현실적인 상황에서 AI가 수행할 수 있는 능력을 측정한다는 점에서 주목받고 있다. 특히 GAIA는 메타(META), 허깅페이스(HuggingFace), 오토GPT(AutoGPT) 등 주요 AI 연구팀이 협업해 만든 벤치마크로, 웹 검색, 멀티모달 이해, 코드 실행 등 실제 업무에 필요한 역량을 평가하는 데 중점을 두고 있다.

GAIA의 테스트는 난이도에 따라 1단계부터 3단계까지 나뉘며, 최대 50단계의 작업을 요구한다. 이는 단순한 답안 추출이 아닌 도구 간 연동과 다양한 추론 과정을 포괄하므로, 실제 기업 환경을 보다 현실적으로 반영한다. 특히 주목할 만한 대목은 하나의 유연한 AI 모델이 GAIA에서 75% 정확도를 기록하며 높은 복잡도를 뛰어넘었고, 이는 마이크로소프트(MSFT)의 매그네틱-1(38%)과 구글(GOOGL)의 랭펀 에이전트(49%) 대비 압도적인 성과라는 점이다.

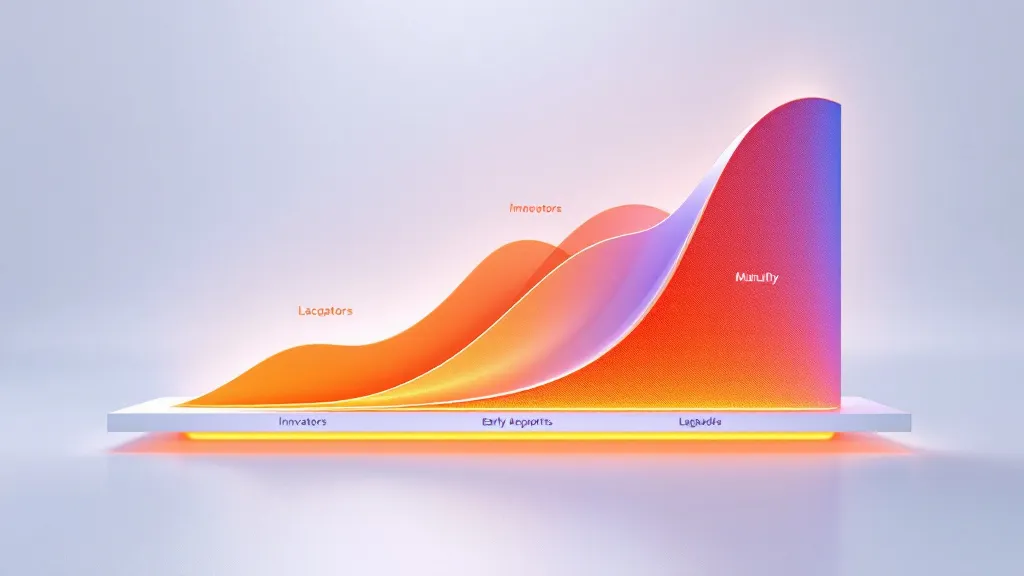

이처럼 GAIA는 SaaS 응용 프로그램 기반의 AI 시대에서 다중 도구를 연동하는 에이전트형 AI로 시장이 전환하는 흐름 속에서, 지능의 본질을 측정할 수 있는 새로운 표준이 되어가고 있다. 단순한 지식 암기와 정답 찾기를 넘어서, AI가 실질적으로 문제를 해결하고 의사결정을 수행할 수 있는지를 가늠하는 진일보한 모델 평가 방식이 필요한 시점이다.

GAIA와 ARC-AGI처럼 AI의 실제 역량을 나타내는 벤치마크가 확산될수록, 기업 및 사용자들은 더 신뢰도 높은 기준에 따라 AI를 선택하고 활용하게 될 것이다. 이는 궁극적으로 '지능'을 추상적 개념이 아닌, 실행 가능한 능력으로 재정의하는 중요한 전환점이라 할 수 있다.

0

0