인공지능(AI)의 존재론적 위험성에 대한 논의가 점점 더 뜨거워지고 있다. AI의 발전 속도가 가속화되면서, 기업 경영진과 연구자들은 AI 시스템이 인간 사회에 미칠 장기적 영향을 신중히 검토해야 한다는 목소리를 높이고 있다.

AI는 이미 금융, 보안, 국방 등 다양한 분야에 걸쳐 사용되고 있으며, 그 역할은 더욱 확대될 전망이다. 그러나 일부 전문가들은 AI가 인간의 가치와 일치하지 않는 방향으로 최적화될 경우 심각한 결과를 초래할 수 있다고 경고한다. 엘론 머스크, 제프리 힌턴, 유발 하라리 등 저명한 인사들도 AI의 잠재력과 위험성을 동시에 강조하고 있다.

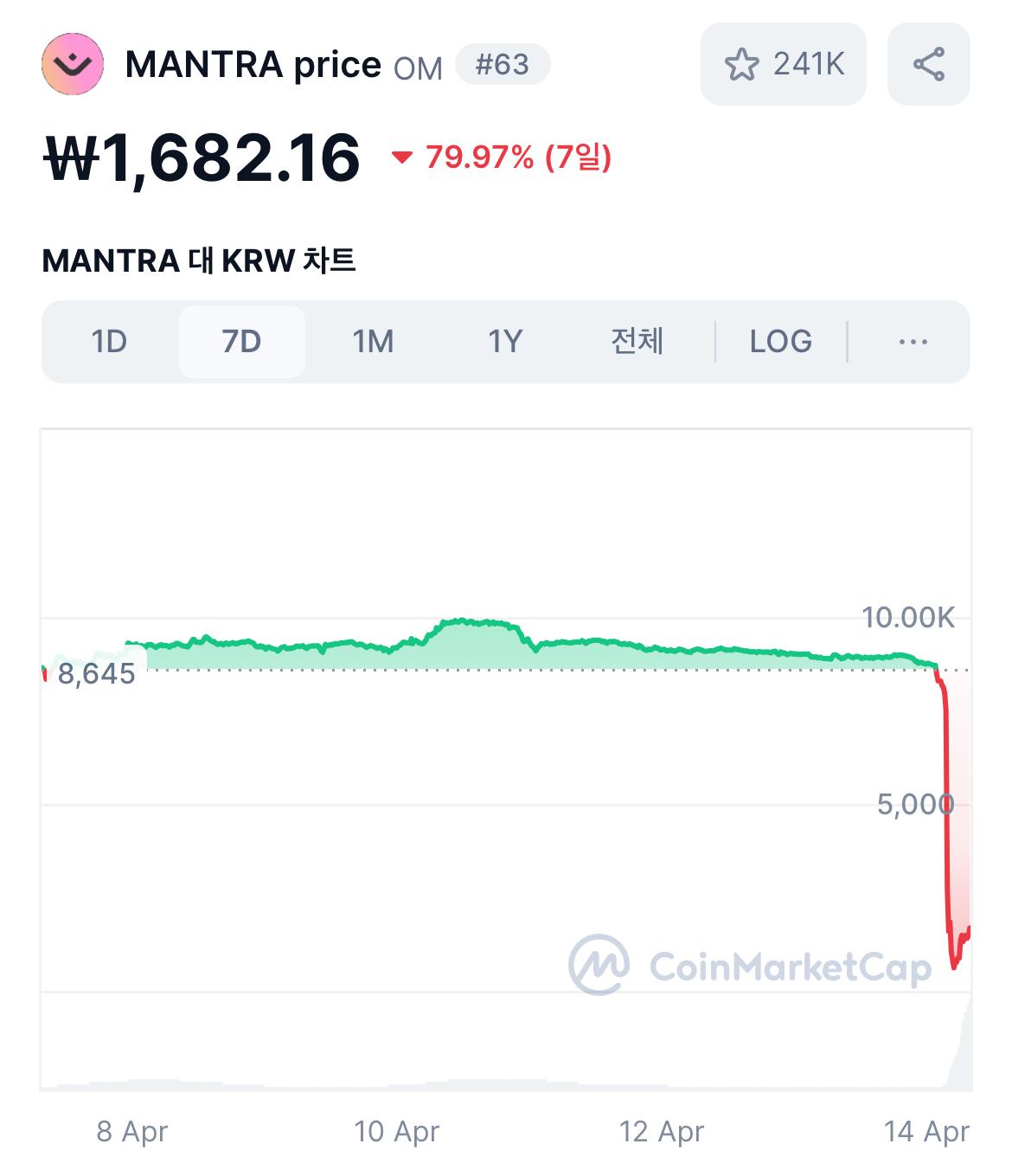

AI의 위험성은 단순히 알고리즘 편향이나 개인정보 보호 문제를 넘어선다. 단기적으로는 금융 시스템 및 보안 시스템의 오작동이 세계 경제에 치명적 영향을 미칠 가능성이 존재하며, 중장기적으로는 인간의 의사결정을 능가하는 ‘일반 인공지능(AGI)’의 등장, 나아가 인간의 통제를 벗어난 ‘초지능(ASI)’의 가능성까지도 고려되고 있다.

특히 AI 개발 방식에 대한 논쟁이 치열하다. 중앙집중형 AI 모델을 선호하는 진영과 다중 에이전트 기반의 분산형 AI를 연구하는 진영 간의 의견 차이가 뚜렷하게 드러나고 있다. 이와 함께 AI 발전 속도를 최대한 높여야 한다고 주장하는 ‘가속주의(Accelerationism)’ 진영과 엄격한 윤리적 규제 도입을 주장하는 ‘효율적 이타주의(Effective Altruism)’ 진영 간에도 치열한 논의가 진행 중이다.

이러한 상황에서 기업 최고정보책임자(CIO)들은 AI 거버넌스 강화가 필수적이라는 점을 인식해야 한다. 블랙박스 모델의 투명성을 높이고, 철저한 리스크 평가 및 지속적인 AI 시스템 감시 체계를 도입해야 한다는 것이다. 또한 기업이 AI 사용을 통제할 수 있는 ‘킬 스위치’ 기능을 포함해야 한다는 주장에도 힘이 실리고 있다.

AI의 발전이 불가피한 가운데, 그 위험성을 최소화하기 위한 전략적 접근이 무엇보다 중요한 시점이다. 기업과 정책 결정자들이 지금 내리는 선택이 향후 AI의 방향을 결정짓는 중요한 전환점이 될 것이다.

1

1