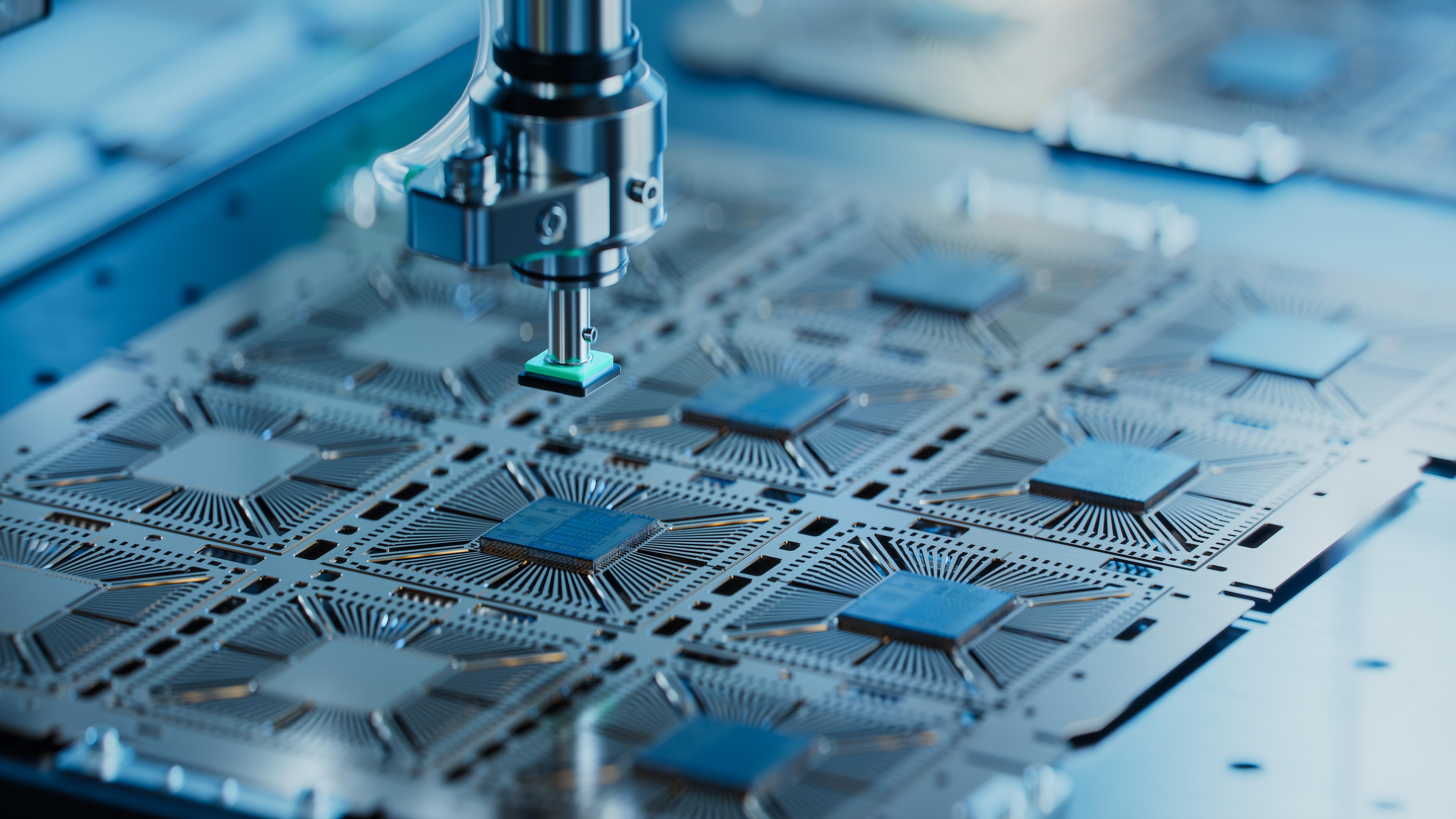

인공지능(AI) 기업 앤트로픽(Anthropic)이 차세대 AI 모델을 대상으로 하는 '탈옥' 프로그램을 발표하며, 참가자들에게 최대 1만5000달러의 상금을 지급할 예정이다.

10일(현지시간) 코인텔레그래프(Cointelegraph)에 따르면, 앤트로픽(Anthropic)은 자사의 미발표 차세대 AI 모델을 대상으로 한 확장된 버그 바운티 프로그램을 공개했다. 이 프로그램에서는 AI의 안전 장치를 우회할 수 있는 '탈옥'에 성공한 참가자에게 최대 1만5000달러의 보상을 제공한다. 초기에는 제한된 인원에게만 참가 기회가 주어지며, 이후 점차 확대될 예정이다.

앤트로픽의 플래그십 AI 모델 클로드-3(Claude-3)는 오픈AI(OpenAI)의 챗GPT(ChatGPT)와 구글(Google)의 제미니(Gemini)와 유사한 생성형 AI 시스템이다. 이번 프로그램은 클로드와 기타 모델들이 안전하게 작동할 수 있도록 보장하기 위해 마련되었다. 앤트로픽은 이를 위해 '레드 팀'이라는 방어적 테스트를 진행한다. 레드 팀은 AI를 일부러 오작동시키거나 잘못된 출력을 유도하는 시도를 통해 모델의 취약점을 찾는 작업이다.

앤트로픽은 자사의 AI 모델에 '헌법적 AI'라는 새로운 안전 개입 방식을 도입했지만, 외부 전문가들의 참여를 통해 추가적인 취약점을 발견하기 위해 이번 프로그램을 마련했다. 회사는 블로그 게시물을 통해 "이번 프로그램은 AI 안전 장치를 일관되게 우회할 수 있는 보편적인 탈옥 공격에 중점을 둔다"고 밝혔다. 이러한 공격은 화학, 생물학, 방사선, 핵(CBRN) 및 사이버 보안과 같은 중요한 고위험 분야에서 발생할 수 있는 주요 취약점을 해결하기 위한 것이다.

이번 프로그램은 AI 탈옥에 대한 경험과 전문성을 가진 연구자들을 대상으로 하며, 오는 8월 16일까지 신청서를 접수받는다. 선정된 참가자들은 앤트로픽의 미발표 차세대 AI 모델에 조기 접근하여 레드 팀 작업을 수행할 기회를 얻게 된다.

뉴스 속보를 실시간으로...토큰포스트 텔레그램 가기

4

4